2021年AIハードウェアサミットに登壇したHugging Face社は、デバイス向けに最適化されたモデルやソフトウェアの統合など、新しいハードウェア·パートナー·プログラムの開始を発表しました。Graphcore社はこのプログラムの創設メンバーです。Hugging Face社と当社のパートナーシップにより、開発者が最先端のトランスフォーマーモデルを簡単に利用できるようになる点についてここでご説明します。

Graphcore社とHugging社は、「イノベーターたちが人工知能の力をより簡単に利用できるようにする」という共通の目標を持つ2つの企業です。

Hugging社のハードウェア·パートナー·プログラムのおかげで、Graphcore社のシステムを利用する開発者は、最小限のコーディングで、当社のIPU(Intelligence Processing Unit)向けに最適化された最先端のトランスフォーマーモデルを量産規模で展開することができます。

Intelligence Processing Unitとは?

IPUとは、Graphcore社のIPU-PODデータセンター·コンピュートシステムを動かすプロセッサです。この新しいタイプのプロセッサーは、AIや機械学習における非常に特殊な計算要件をサポートするように設計されています。微細な並列処理、低精度演算、スパース性への対応などの特徴がシリコンに組み込まれています。

Graphcore社のIPUは、GPUのようなSIMD/SIMTアーキテクチャではなく、超並列MIMDアーキテクチャを採用しており、超広帯域メモリをプロセッサコアに隣接する形でシリコンダイ上に配置しています。

この設計により、BERTやEfficientNetなど、現在最も人気のあるモデルを実行する場合でも、次世代のAIアプリケーションを探求する場合でも、高いパフォーマンスと新しいレベルの効率性を実現します。

IPUの能力を引き出すには、ソフトウェアが重要な役割を果たします。当社のPoplar SDKは、グラフコアの設立当初から、プロセッサと共同で設計されています。現在では、PyTorchやTensorFlowなどの標準的な機械学習フレームワークや、DockerやKubernetesなどのオーケストレーションおよびデプロイメントツールと完全に統合されています。

広く使われているサードパーティのこれらのシステムとの互換性をPoplarに持たせたことで、開発者はモデルを他の計算プラットフォームから簡単にポートし、IPUの高度なAI機能を利用できるようになりました。

生産に向けたトランスフォーマーの最適化

トランスフォーマーは、AIの分野を完全にトランスフォームしました(シャレのつもりです)。Graphcore社のお客さまは、NLPをはじめとする様々なアプリケーションでBERTのようなモデルを広く使用しています。これらの多才なモデルには、特徴抽出、テキスト生成、感情分析、翻訳など様々な機能が搭載されています。

Hugging Face社では既に、フランス語のCamemBERTから、NLPで学んだことをコンピュータビジョンに応用したViTまで、何百ものトランスフォーマーが活躍しています。トランスフォーマーのライブラリは、毎月平均200万回ダウンロードされており、その需要はますます高まっています。

5万人以上の開発者ユーザーベースを持つHugging Face社は、オープンソースプロジェクトにおいて最も速く導入してきました。

現在Hugging Face社は、ハードウェア·パートナー·プログラムを通して、究極のトランスフォーマーツールセットと今日の最先端のAIハードウェアをつなげています。

開発者は、新しいオープンソースのライブラリとツールキットであるOptimumを使用することで、ハードウェア向けに最適化されたHugging Face社認定済モデルにアクセスすることができます。

これらは、Graphcore社とHugging Face社が共同開発したものです。IPU向けに最適化された最初のモデルは、今年の終わりにはOptimumに登場する予定です。最終的には、視覚や音声、翻訳やテキスト生成など、幅広い用途に対応できるようになります。

Hugging Face社のCEO、クレメント·デランジュ氏は次のように述べています:「開発者は誰でも、Graphcore社のIPUのような最新のハードウェアを手に入れたいと思っています。ですがその一方で、新しいコードやプロセスを学ばなければならないのではないかという疑問が常につきまといます。OptimumとHugging Faceのハードウェアプログラムなら問題ではありません。基本的に、プラグアンドプレイなのです。」

SOTAモデルとSOTAハードウェアの出会い

Hugging Face社との提携の発表に先立ち、PyTorchを使用したHugging Face BERTにおける特別なGraphcoreの最適実装によって、当社は最先端のトランスフォーマーモデルを高速化するIPUの実力を実証しました。

この例についての詳細は、ブログBERT-Large training on IPU explainedでご覧いただけます。

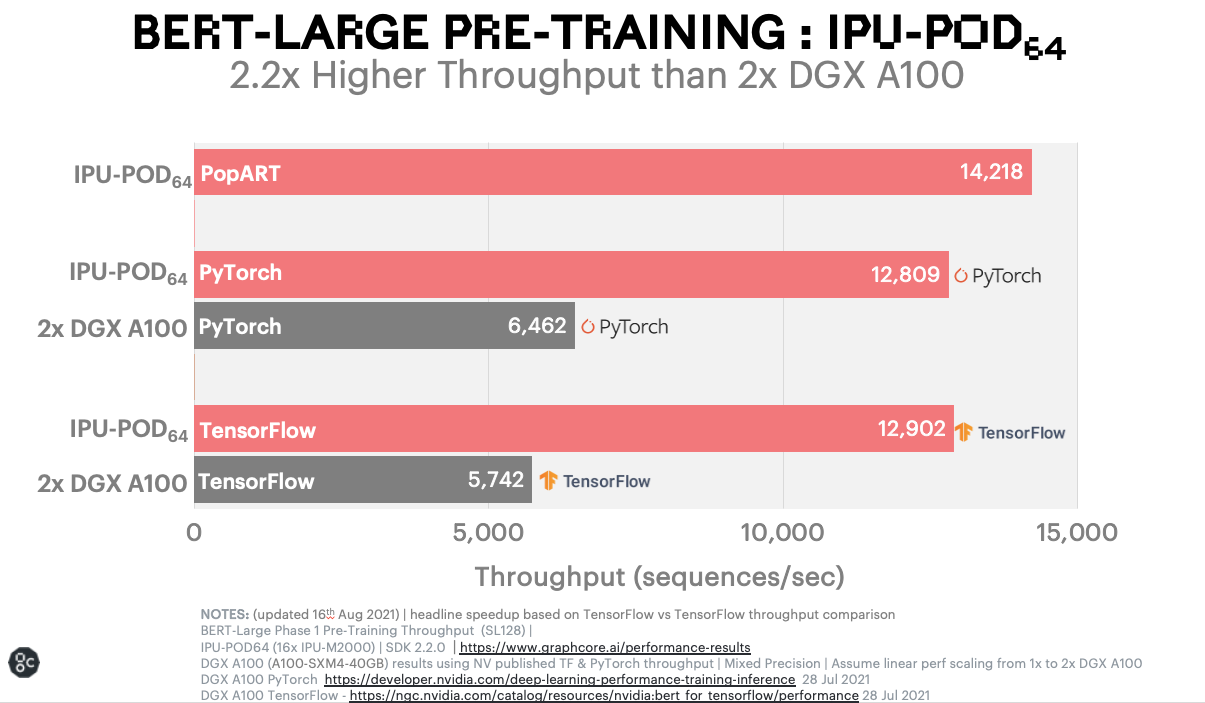

Graphcore社のシステム上で動作するBERTのベンチマーク結果は、同等のGPUベースのシステムと比較しても劇的な結果となっています。現在、IPU以外で人気のNLPモデルを動作させている人にとっては、非常に興味深い結果であるはずです。

BERT-Largeのプレトレーニング: IPU-POD64

このような高速化により機械学習の研究者やエンジニアにとって大きな変化があらわれるため、貴重な時間をトレーニングに費やす価値があるのです。さらに、新しいモデルを開発する際の反復回数を増やすこともできます。

Graphcoreのユーザーは、洗練され、シンプルで優れたさまざまなモデルを持つHugging Face社のプラットフォームを通じて、このようなパフォーマンスメリットを引き出せるようになります。

Hugging Face社とGraphcore社が共に力を合わせることで、より多くの人々がトランスフォーマーの恩恵を受け、AI革命を加速することができるのです。

Hugging Face社のハードウェア·パートナー·ポータルにアクセスして、詳細をご覧ください。