この度Graphcoreは、AI業界で最も広く知られている比較ベンチマークプロセスのMLPerfTMによる学習評価を初めて受けました。

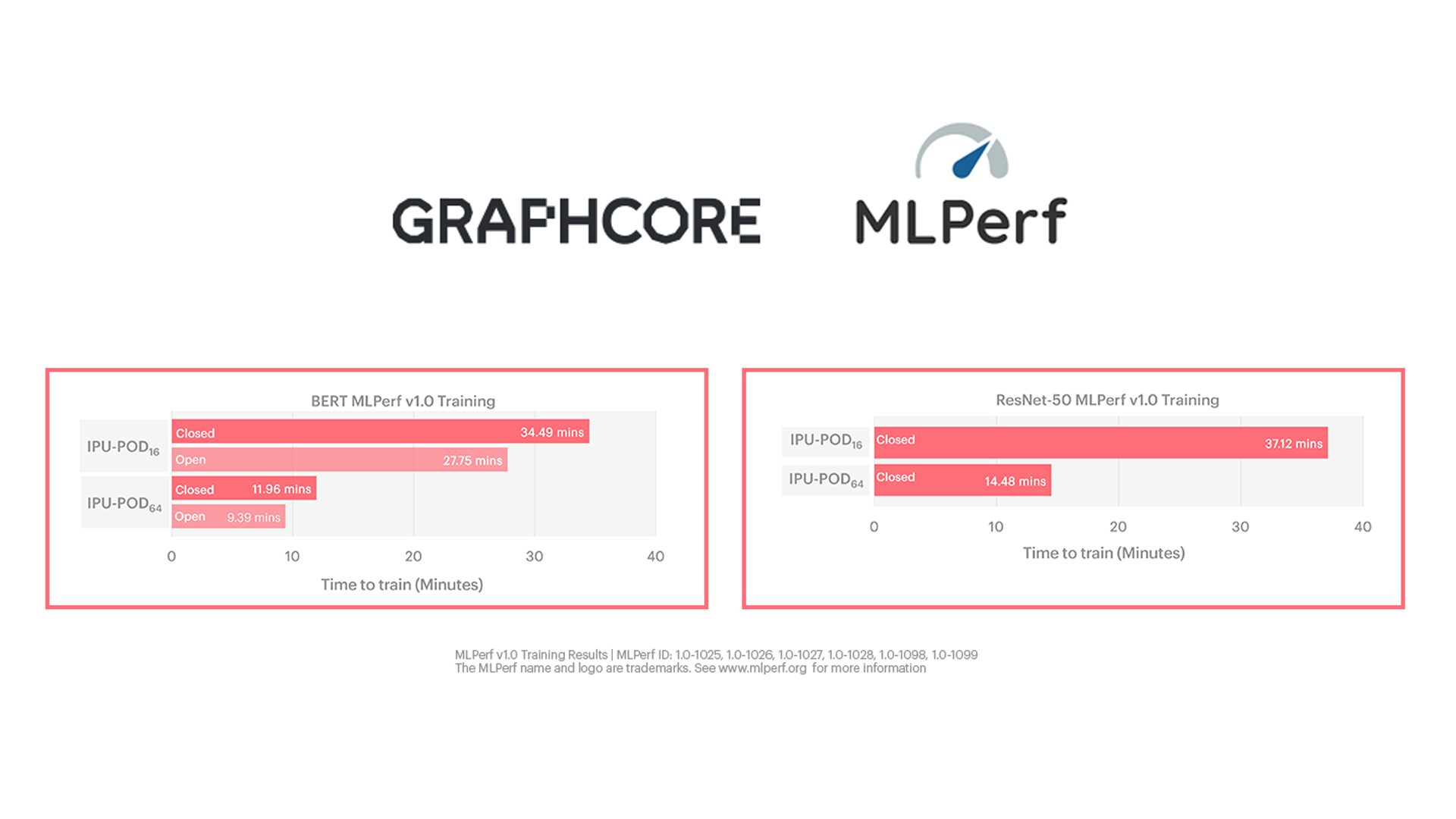

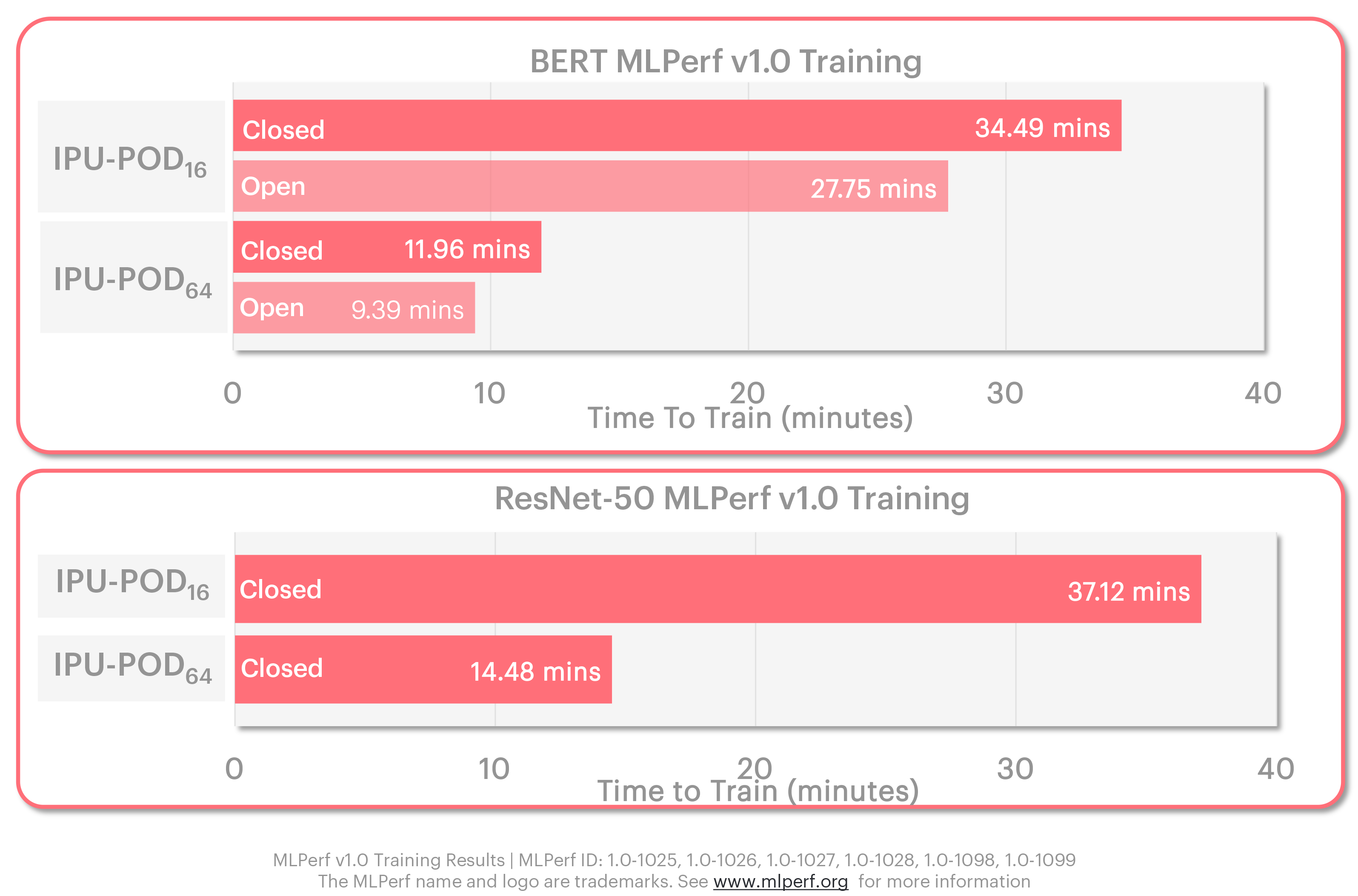

その結果、IPU-POD64においてBERTの学習時間はわずか9分強、ResNet-50の学習時間は14.5分と優れた結果が得られました。 これはスーパーコンピュータレベルのAIパフォーマンスです。

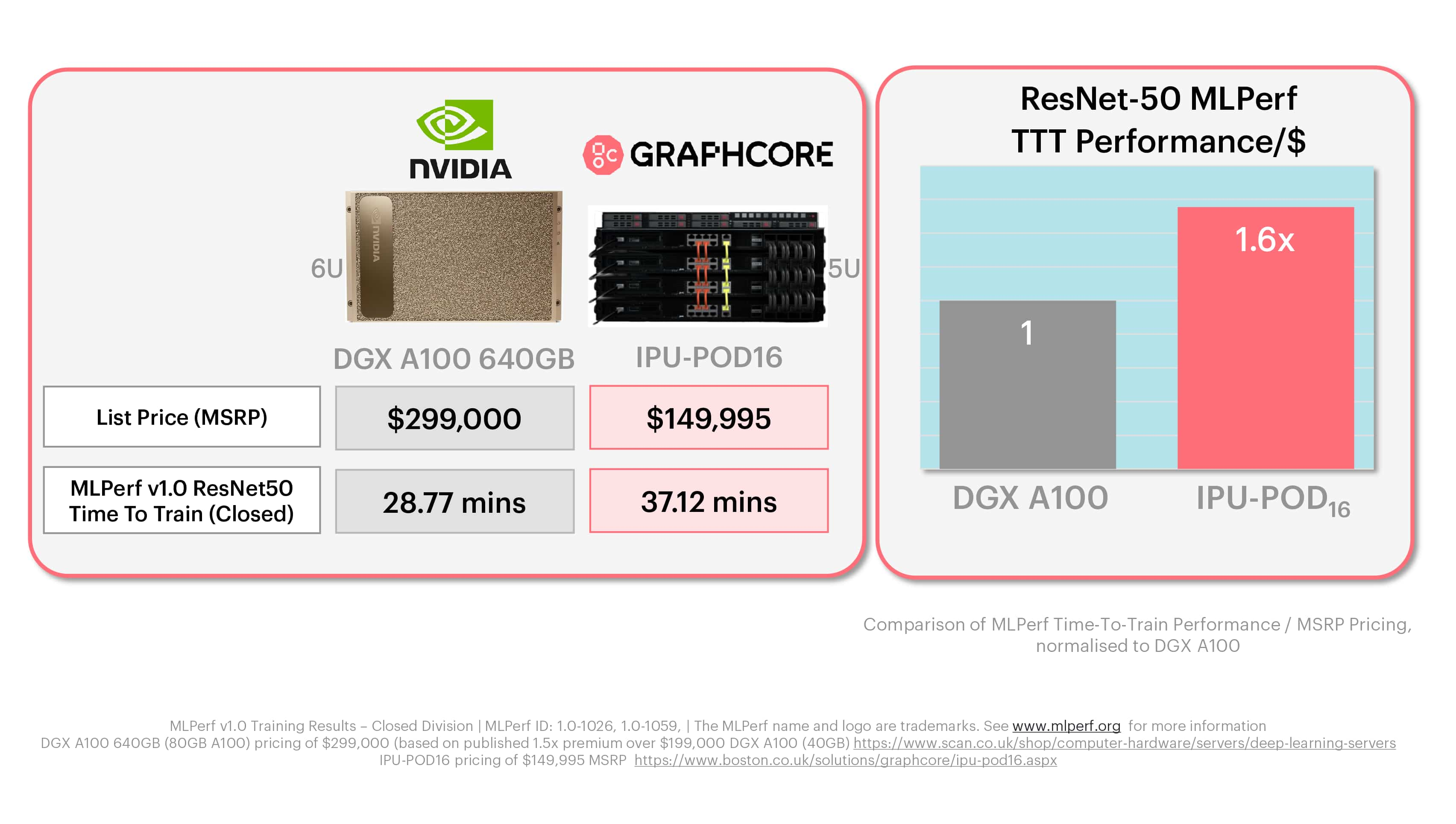

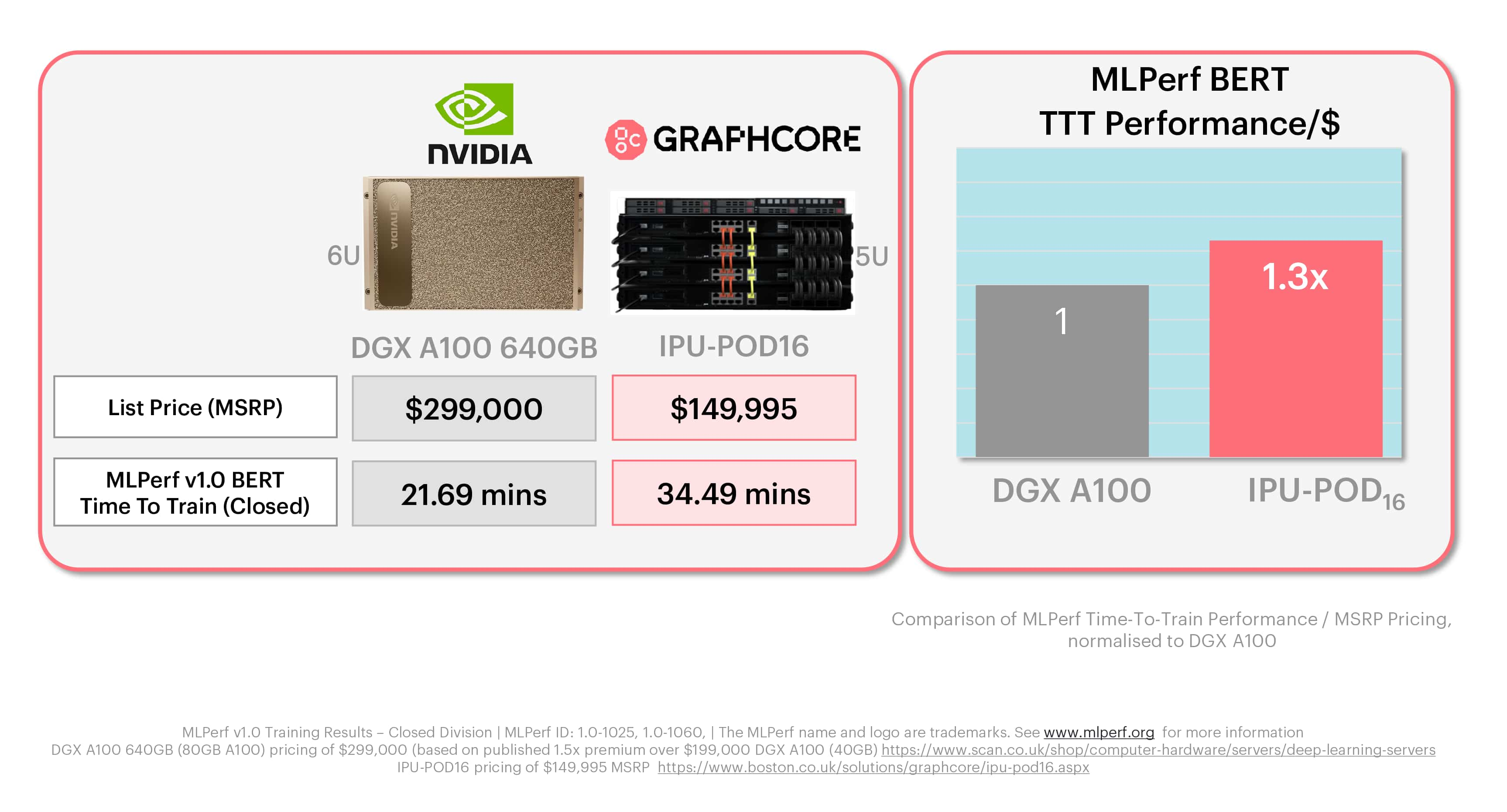

MLPerfでは、市販されているGraphcoreのシステムとNVIDIAの最新システムとの比較も示されており、1ドルあたりのパフォーマンス指標では当社が優位に立っています。

Graphcoreのシステムが単に次世代のAIにおいて優れていることだけでなく、現在最も広く使用されているアプリケーションにおいても優れていることがサードパーティによって確認されたということは、お客様にとって大きな意味を持ちます。

成熟したソフトウェアスタックや革新的なアーキテクチャ、高パフォーマンスのシステムを誇るGraphcoreがAIコンピュートの分野で注目すべき企業であることは、もはや疑いの余地がありません。

イノベーションを加速させる

Graphcoreが創設メンバーとして参加しているMLPerfは、MLCommonsTMによって監督されているコミュニティで、他にも人工知能分野のメンバーや関連会社、非営利団体、営利企業が50社以上参加しています。

MLCommonsの任務は「機械学習のイノベーションを加速させ、社会へのプラスの影響を増大させること」であり、当社はこの偉大な目標を全面的に支持しています。

学習と推論の結果は四半期ごとに、交互に発表されます。Graphcoreが提出した最新の学習ラウンドの生データは、こちらでご覧いただけます。

アプリケーションとモデル

今回当社が初めて提出したMLPerf(学習バージョン1.0)では、アプリケーションベンチマークの主要カテゴリーである「画像分類」と「自然言語処理」に焦点を当てることにしました。

MLPerfの画像分類ベンチマークでは定番のResNet-50バージョン1.5モデルが使用され、全評価対象に共通する規定の精度に達するまでImageNetデータセットで学習されます。

NLPについては、BERT-Largeモデルが使用されており、セグメントは全学習コンピュートワークロードの約10%に相当し、Wikipediaデータセットを使用して学習されます。

当社が、ResNet-50とBERTを用いた画像分類とNLPに提出することを決めた背景には、それらをアプリケーションやモデルとして最も頻繁に使用するお客様や、潜在的なお客様の存在が大きく影響しています。

MLPerfにおける当社の強力なパフォーマンスは、当社のシステムが今日のAIコンピュートの要求に応えることができることを示す、さらなる証拠です。

Graphcoreのシステム

今回、Graphcoreの2つのシステム、IPU-POD16 とIPU-POD64でMLPerfの学習評価を受けました。

この2つのシステムはどちらも、製造中のお客様にすでに出荷されているものなので、プレビューではなく「市販」のカテゴリーにエントリーしました。これは、MLPerfへの初の提出としては大きな成果です。

IPU-POD16は、Graphcoreが開発したコンパクトな5Uサイズのシステムで、IPU AIコンピュート能力の構築を始めた企業のお客様向けに手頃な価格で提供されています。このシステムは4台の1U IPU-M2000と1台のデュアルCPUサーバーで構成され、4ペタフロップスのAI処理能力を発揮します。

もう一方のスケールアップしたIPU-POD64は、16台のIPU-M2000と台数を自由に選べるサーバーで構成されています。GraphcoreのシステムではサーバーとAIアクセラレータが分散されているので、お客様は実際のワークロードに応じてCPUとIPUの比率を指定できます。例えばコンピュータビジョンのタスクは、一般的に自然言語処理よりもサーバーへの要求が高くなります。

そこでMLPerf用に、IPU-POD64はBERTにサーバーを1台、ResNet-50にサーバーを4台使用しました。そして各サーバーにAMD EPYC™ CPUを2つ搭載しています。

オープン提出とクローズド提出

MLPerfにはオープンとクローズドの2つの提出部門があります。

クローズド部門では、モデルの実装やオプティマイザのアプローチが全く同じであることが提出者に厳格に要求され、これにはハイパーパラメータの状態や学習エポックの定義も含まれます。

オープン部門は、クローズド部門と全く同じモデルの精度と品質を確保しつつ、モデルの実装に柔軟性を持たせることでイノベーションを促進することを目的としています。その結果、さまざまなプロセッサの能力やオプティマイザのアプローチに合わせて微調整された、より高速なモデルの実装が後押しされます。

当社のIPUのような革新的なアーキテクチャの場合、オープン部門の方が当社のパフォーマンスがより顕著に表れる思いますが、当社はオープンとクローズドの両方の部門に提出することを選択しました。

GraphcoreによるMLPerf評価結果:オープン部門とクローズド部門

これらの結果からは、仕様に関する制約の多い、従来の常識を破るようなクローズド部門でもGraphcoreのシステムは高いパフォーマンスを発揮していることがわかります。

さらに印象的なのはオープン部門での結果で、当社のIPUとシステムの能力を最大限に活用した、最適化のようなものを示すことができました。これらの事実は、お客様がパフォーマンス向上のメリットを享受できる、現実的なユースケースをより如実に反映するものです。

価格/パフォーマンス

MLPerfは比較ベンチマークとして知られ、多くの場合は、あるメーカーの技術を別のメーカーの技術と比較して評価するときに基準として用いられます。

事実、直接比較することは複雑になることがあります。 今日のプロセッサやシステムのアーキテクチャは、比較的シンプルなシリコンから高価なメモリを搭載した複雑なスタックチップまで多岐にわたっています。

お客様と同じように当社も、1ドルあたりのパフォーマンスに基づく結果を一番有益な情報として注目します。

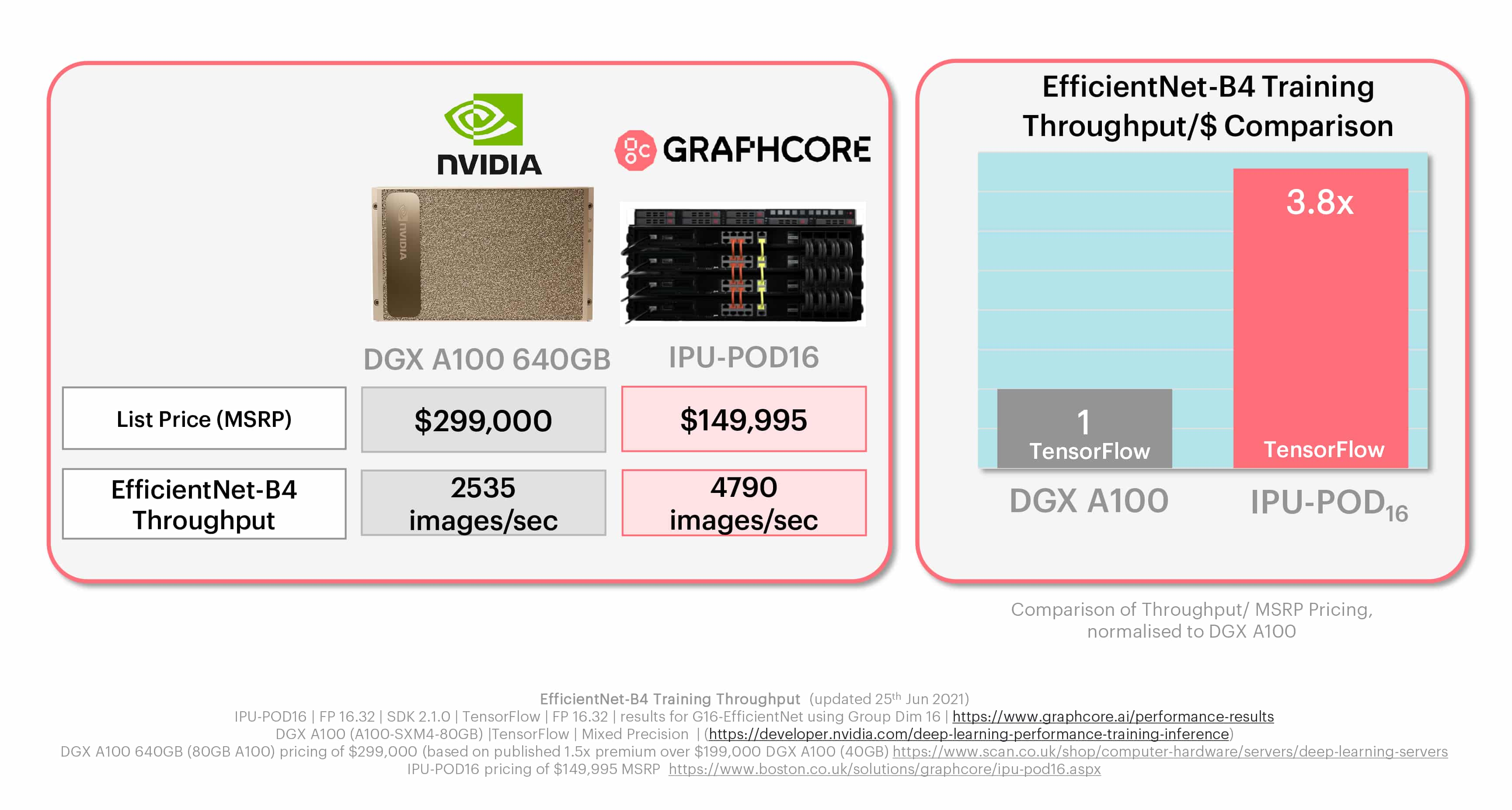

GraphcoreのIPU-POD16は5Uシステムで、小売希望価格は149,995ドルです。すでに説明したようにこのシステムは、それぞれに4つのIPUプロセッサを搭載した4台のIPU-M2000アクセラレータと、業界標準のホストサーバーで構成されています。MLPerfで使用されているNVIDIA DGX-A100 640GBは、小売希望価格が約300,000ドル(市場情報と公表されている再販業者の価格に基づく)の6Uボックスで、DGX A100チップが8個搭載されています。

それに対してIPU-POD16は半分の価格です。アクセラレータに着眼してこの結果を見た場合でも、当社のシステムではIPU-M2000 1台がA100-80GB 1台と同じ価格であり、より細かく見ればIPU 1台の価格は4分の1であることがわかります。

当社が行ったMLPerfの比較分析では、制約の厳しいクローズド部門の結果を採用し、標準化してシステム価格にしています。

結果

ResNet-50とBERTの両方において、Graphcoreのシステムの方がNVIDIAの製品よりも1ドルあたりのパフォーマンスにおいて著しく良いことは明らかです。

IPU-POD16が示した1ドルあたりのパフォーマンスは、ResNet-50の学習では1.6倍、BERTでは1.3倍となっています。

MLPerfの学習:ResNet-50

MLPerfの学習:BERT

これらのMLPerfのチャートは、実際のGraphcoreのお客様が体験していることを反映しています。つまり、AI向けに構築されたIPUのアーキテクチャにより、当社のシステムの経済的側面がAIコンピュートの目標達成に役立つと同時に、次世代のモデルや技術の未来を切り開いているということです。

取り組みの継続

初めて提出したMLPerfの評価でこのような結果が得られたことを、当社はとても誇りに思っています。このような結果を得るために、当社のカスタマーエンジニアリンググループから選ばれた少人数のエンジニアチームをはじめ、全社を挙げてとても熱心に取り組んできました。

また、今回の参加を支えるあらゆる改良と最適化が現に当社のソフトウェアスタックに組み込まれていることを踏まえると、当社が提出した意義はいっそう深くなります。世界中のGraphcoreユーザーはすでに、BERTやResNet-50よりもはるかに多くのモデルでMLPerfの評価結果から恩恵を受けています。

当社は学習ラウンドと推論ラウンドの両方において、MLPerfに継続して参加することを約束します。そして、より良いパフォーマンス、より大きなスケール、より多くのモデルの追加という3つの目標を目指します。

パフォーマンス

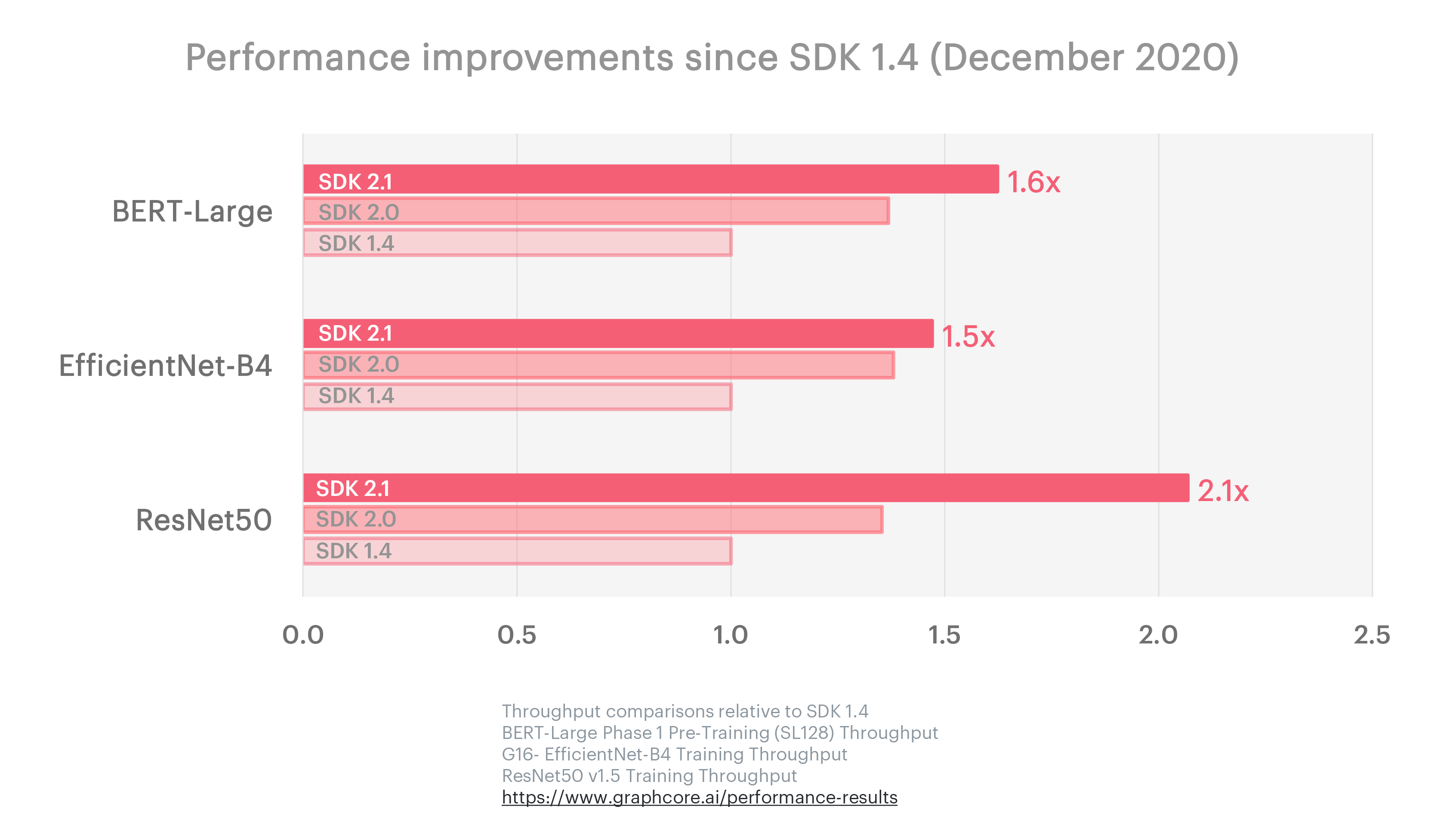

当社が継続的なソフトウェアの改良に注力していることは、Poplar SDKの最近のリリースで確認されたベンチマークの進歩にも表れています。2020年12月から2021年6月までの半年間に行われた3回のアップデートで、当社はResNet-50で2.1倍、BERT-Largeで1.6倍、ResNetよりもさらに高精度を重視したコンピュータビジョンモデルであるEfficientNetで1.5倍のパフォーマンス向上を実現しました。

Graphcoreの研究チームは、ソフトウェアの継続的な改良を追求すると同時に、現行モデルと次世代モデルの可能性の限界に挑戦しています。彼らが最近発表した「EfficientNetの効率を高める」や「アクティベーションのプロキシ正規化によるCNNにおけるバッチ依存性の排除」は、MLPerfの評価に向けた準備作業に直接関連しており、Graphcoreのお客様だけでなく、より広いAIコミュニティに利益をもたらすものです。

現在最も広く使用されているAIモデルでのパフォーマンスを示すために、最初にResNet-50とBERTでMLPerfに提出することが重要でした。

しかしGraphcoreのIPUとそれを搭載したシステムは、次世代のAIアプリケーションを得意とし、レガシーなプロセッサアーキテクチャの制限を受けずに、ユーザーが新しいモデルや技術を開発できるように設計されています。

その一つがEfficientNet-B4です。これはより高度な、しかし現在も広く使用されているコンピュータビジョンモデルで、1ドルあたりのパフォーマンスの面でIPUとGPUの間には大きな差があることを示す良い例です。

MLPerfの学習:EfficientNet-B4(非MLPerf)

MLPerfがこのような革新的なモデルと歩調を合わせながら、今日の最も一般的なユースケースも同時に反映していくことで、お客様やAI業界が恩恵を受けることになると当社は考えます。

Graphcoreは今後も、当社の技術を利用する人のためだけでなく、利用していない人のためにも、積極的で進歩的なMLCommonsメンバーとして活動していきます。

差し当たり、初めての提出にはとても満足しており、次の提出に向けてすでに準備を進めています。

GraphcoreによるMLPerf v1.0学習結果 | MLPerf ID:1.0-1025、1.0-1026、1.0-1027、1.0-1028、1.0-1098、1.0-1099

MLPerfの名称およびロゴは商標です。詳しくは、www.mlperf.orgをご覧ください。